виртуальная видеокарта что это

«Не процессором единым»: Виртуальные GPU

Объемы данных, накапливаемых в мире, растут, поэтому появляются все новые способы их обработки. Один из способов повышения скорости вычислений – совместное использование центрального (CPU) и графического процессора (GPU). Вычисления с GPU-ускорением были придуманы еще в 2007 году компанией Nvidia, но теперь технология вышла на новый уровень и применяется в дата-центрах крупнейших научных лабораторий и предприятий.

Мы уже затрагивали тему виртуализации в своем блоге, когда говорили о том, как и кем используется виртуальная инфраструктура. Сегодня нам бы хотелось рассказать вам, как работают виртуальные графические процессоры и какие GPU-технологии существуют на рынке.

Вычисления на GPU используются не только в компьютерных играх и при работе с видеоконтентом. Например, NASA, по заявлению одного из ученых-метеорологов, использует GPU в моделях GEOS-5 для увеличения эффективности численного моделирования атмосферных явлений. Это позволяет повысить доступность системы для большего числа людей, гарантируя разрешение 100–200 км/пиксель.

Вычисления с GPU-ускорением применяются и в бизнес-аналитике. Так, по словам старшего научного сотрудника HP Labs Рена Ву (Ren Wu), GPU позволили увеличить производительность используемых аналитических систем в 5–20 раз.

Сравнение центрального и графического процессоров

Архитектуры CPU и GPU изначально «заточены» под решение разных задач. Центральный процессор решает задачи общего назначения: исполнение набора последовательных инструкций, управление периферийными устройствами и так далее, поэтому обычно он содержит от 2 до 18 ядер, имеющих сложную структуру.

GPU же изначально проектировался для работы с графикой, потому состоит из большего числа энергоэффективных ядер, способных обрабатывать до нескольких тысяч потоков одновременно. При этом на GPU выполняется лишь часть самых ресурсоемких вычислений, а остальное отдается CPU.

Использование подобного рода вычислений актуально в научной сфере, поэтому для выполнения объемных научных расчетов создаются суперкомпьютеры, «начиненные» GPU. Однако несмотря на все преимущества подобного рода вычислений, закупка физического оборудования выливается в серьезные денежные траты. Более того, «железо» имеет тенденцию к устареванию, потому его приходится регулярно обновлять.

Технология vGPU

Эти проблемы призвана решить технология виртуальных графических процессоров (vGPU), представленная Nvidia, которая дает пользователям возможность удаленно запускать графикоемкие приложения. Здесь стоит отметить, что до появления vGPU применялись другие методы ускорения обработки графики:

Такой решение, как показало тестирование, проведенное сотрудниками компании VMware, оказалось достаточно состоятельным. В своей работе они описали результаты тестов приложений с использованием продуктов VMware: Workstation 6.5 и Fusion 2.0. Им удалось установить, что производительность Half-Life 2: Episode 2 и Civilization 4 при использовании виртуальных GPU была близка к фактической (как если бы игры запускали на физической машине).

Но технология vGPU находит применение в самых разных сферах: архитекторы и инженеры используют её в системах автоматизированного проектирования (например в Autodesk BIM), а дизайнеры работают с цифровым фото- и видеоконтентом (например в Adobe Photoshop). Она также применяется работниками из сферы здравоохранения, которые пользуются системами передачи и архивации медицинских изображений и документов обследованных пациентов (PACS), такими как GE Centricity EMR.

Стоит отметить, что до недавних пор невозможно было организовать доступ множества пользователей к одному GPU. Если 32 человека хотели обратиться к чертежам в AutoCAD со своих ВМ, то приходилось приобретать 8 дорогих видеокарт с 4 GPU. Эту проблему решила технология Nvidia GRID. Её суть заключается в совместном использовании vGPU несколькими виртуальными десктопами, к которым предоставляется прямой доступ с помощью драйверов Nvidia.

Фактически последняя версия Nvidia GRID 2.0 позволяет перенести всю работу в виртуальное пространство. Обновленная технология поддерживает до 128 пользователей на сервере и значительно увеличивает производительность приложений. Также GRID 2.0 позволяет запускать виртуальные десктопы на блейд-серверах и поддерживает не только ОС Windows, но и Linux.

Настройка режима vGPU для карт Nvidia в VMware vSphere 6

/ фото ChrisDag CC

Компания VMware ввела функцию виртуальных GPU в обновлении своей платформы виртуализации vSphere 6.0. Технология vGPU от Nvidia при использовании с продуктами VMware подразумевает использование в качестве платформы VMware vSphere 6, а в качестве средства управления виртуальными ПК – VMware Horizon 6.

vGPU поддерживается для графических адаптеров Nvidia GRID K1 и K2, для каждого из которых определены 4 профиля использования ресурсов видеокарты. Вот таблица их вариантов:

В данной таблице приведены три типа пользователей:

После того как Nvidia vGPU Manager настроен на хост-серверах ESXi, нам нужно подготовить виртуальные машины. Это делается через vSphere Web Client, где выбираются аппаратные характеристики ВМ в зависимости от типа рабочей нагрузки.

Затем в настройках ВМ нужно добавить Shared PCI Device, а также выбрать тип Nvidia GRID vGPU и профиль в соответствии с приведенной выше таблицей. После этого можно устанавливать гостевую ОС (Windows 7 и более поздние версии).

Теперь остается установить драйвер Nvidia GRID и настроить пул виртуальных ПК в VMware Horizon View: просто указываем протокол PCoIP и тип 3D-рендера Nvidia GRID VGPU. На этом все. Виртуальные машины готовы к работе с vGPU.

Виртуальная видеокарта что это

Функция искусственного разделения ресурсов видеокарты на несколько виртуальных задач в настоящее время ограничена Grid/Tesla и рабочими станциями графических процессорах Quadro. Эта функция недоступна для игровой серии GeForce. По крайней мере, такой возможности не былодо сих пор. Благодаря довольно простому модулю под названием «vgpu_unlock» эта функция теперь может быть включена в потребительских графических картах.

реклама

Теоретически теперь должна быть возможность включить одну видеокарту GeForce RTX 3090 для работы нескольких виртуальных машин и использовать ее для игр. Это было бы интересным решением проблемы нехватки графических карт. Особенно такая возможность может быть полезна в различных интернет-кафе и компьютерных клубах, которые могут использовать один графический процессор для работы нескольких компьютеров.

Мод на самом деле довольно прост, он обманом заставляет драйвер считывать другой идентификатор устройства PCI. Карты на архитектурах Pascal, Turing и Ampere интерпретируются драйвером, как карты Quadro или Tesla. Мод работает с программным обеспечением виртуальных машин Linux и KVM. Хотя хост-компьютер не может работать на операционной системе Microsoft Windows, виртуальные машины, которые будут подключены к основной системе, имеют такую возможность.

Таким образо, чтобы определить, поддерживает ли конкретный графический процессор функциональность vGPU, драйвер смотрит на идентификатор устройства PCI. Этот идентификатор вместе с идентификатором поставщика PCI уникален для каждого типа устройства. Чтобы включить поддержку vGPU, нужно сообщить драйверу, что идентификатор устройства PCI установленного графического процессора является одним из идентификаторов устройств, используемых графическим процессором с поддержкой vGPU.

Список всех поддерживаемых на данный момент видеокарт довольно обширен. Ознакомиться с ним можно, взглянув на изображение ниже.

3D ускорение VDI на практике. Часть 1

3D ускорение VDI на практике.

Часть 1 — vSGA и vDGA

Отсутствие аппаратного ускорения графики является существенным препятствием при внедрении технологий виртуализации в компаниях, работающих в сфере дизайна, проектирования, конструкторских разработок и пр. Рассмотрим, какие новые возможности появились с выходом NVIDIA GRID.

Виртуализация рабочих мест (VDI) уже прочно вошла в нашу жизнь, в первую очередь в корпоративном сегменте рынка, и уверенно пробивает путь в остальные сегменты, в том числе и в виде публичных облачных сервисов (Desktop as a Service). Отсутствие же аппаратного ускорения графики сдерживает использование данной технологии в тех отраслях, которые могли бы оценить такие преимущества использования VDI как удаленную доступность, безопасность данных и упрощение аутсорсинга персонала.

Первые шаги к использованию 3D ускорения в VDI были сделаны достаточно давно и заключались в пробросе PCI устройств в виртуальные машины, что позволяло выдавать для VDI видеокарты, установленные в сервер или подключенные к серверу с помощью внешних PCIe корзин, например, таких как Dell PowerEdge C410x. Недостатки такого решения очевидны — повышенное использование электроэнергии, места в стойках и высокая стоимость.

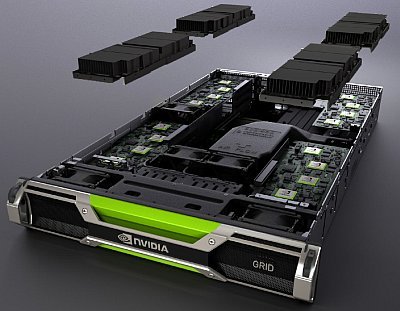

Коротко о технологии NVIDIA GRID

С анонсом технологии NVIDIA GRID (NVIDIA VGX на момент анонса) в прошлом году интерес к использованию 3D ускоренных VDI значительно возрос. Суть технологии GRID, которая исходно предназначена именно для 3D ускорения в виртуальных средах, достаточно проста и включает в себя следующие принципы:

| GRID K1 | GRID K2 | |

| Число GPU | 4 Kepler GPU начального уровня | 2 Kepler GPU высокого класса |

| Ядра CUDA | 768 | 3072 |

| Общий размер памяти | 16 ГБ DDR3 | 8 ГБ GDDR5 |

| Максимальная мощность | 130 Вт | 225 Вт |

| Длина Карты | 26,7 см | 26,7 см |

| Высота Карты | 11,2 см | 11,2 см |

| Ширина Карты | Dual Slot | Dual Slot |

| Отображение ввода/вывода данных | Нет | Нет |

| Дополнительное питание | Разъем 6-pin | Разъем 8-pin |

| PCIe | x16 | x16 |

| Поколение PCIe | Gen3 (совместим с Gen2) | Gen3 (совместим с Gen2) |

| Охлаждение | Пассивное | Пассивное |

| Технические спецификации | Спецификации платы GRID K1 | Спецификации платы GRID K2 |

Фактически, GRID K1 представляет собой интегрированные на одной PCIe карте четыре карты уровня QUADRO K600, карты GRID K2 — две карты уровня QUADRO K5000. Это позволяет даже без использования виртуализации существенно увеличить плотность графических адаптеров в серверах.

Включение в платформу GRID серверов различных вендоров, обеспечивающих установку до 4 карт GRID в один сервер избавляет от необходимости применять внешние PCIe корзины.

ПО, поддерживающее технологию GRID — это гипервизоры VMware, Citrix и Microsoft, а также системы виртуализации рабочих станций VMware и Citrix (и Microsoft, если рассматривать варианты общего доступа к серверу).

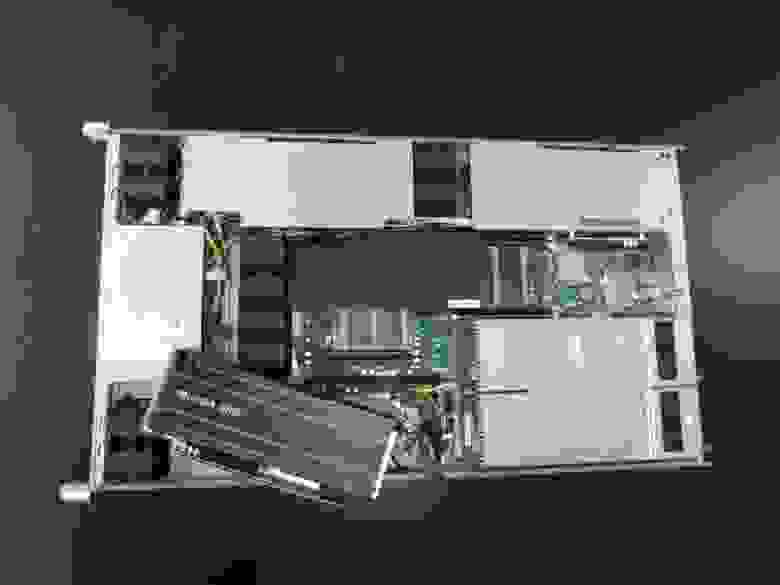

Описание нашего тестового стенда

SATA корзина позволяет использовать недорогие SSD диски для Host Based кэширования доступа к данных, столь полезного при VDI нагрузках, с характерными пиками дисковой активности в начале и окончании рабочего дня.

При современных же ценах на модули памяти восьми DIMM-слотов оказывается вполне достаточно в ситуации, когда плотность VM на сервер ограничивается CPU и GPU ресурсами.

В данный сервер мы установили карту NVIDIA GRID K1. Приводим фото сервера с готовой к установке видеокартой:

В качестве платформы виртуализации была выбрана привычная нам VMware vSphere. Забегая вперед, отмечу, что во второй части данной статьи нам придется использовать Citrix XenServer, поскольку на данный момент только он и только в статусе Tech Preview поддерживает технологию GRID Virtual GPU.

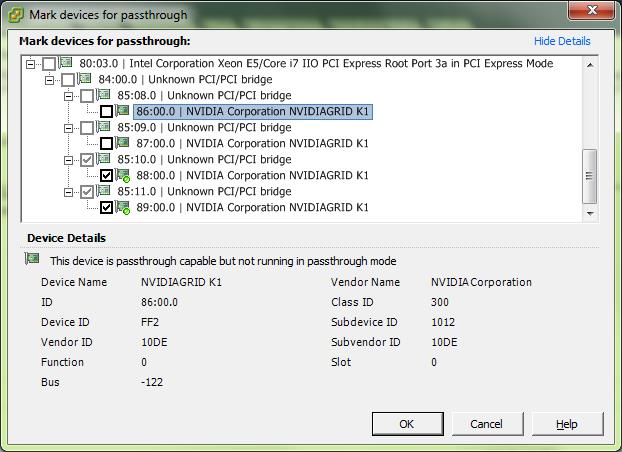

Гипервизор ESXi определяет видеокарту как 4 устройства NVIDIAGRID K1, подключённые через PCI/PCI bridge, что делает ускорители доступными для раздельного использования как passthrough устройства, подключаемые к ВМ, или как основу для виртуализации на уровне гипервизора.

В гипервизор инсталлируется драйвер от NVIDIA:

# esxcli software vib list | grep NVIDIA

NVIDIA-VMware_ESXi_5.1_Host_Driver 304.76-1OEM.510.0.0.802205 NVIDIA VMwareAccepted 2013-03-26

Все устройства, которые не переведены в режим passthrough, при загрузке инициализируются и используются драйвером от NVIDIA:

В качестве платформы для создания инфраструктуры VDI используется продукт Citrix XenDesktop 7, который в настоящий момент используется и в нашей production инфраструктуре, предоставляющей сервисы VDI для наших заказчиков. На тестовых машинах используется технология HXD 3D Pro, осуществляющая эффективную упаковку и проброс на клиента отрендеренного GPU изображения. Тестовый виртуальный сервер имеет следующую конфигурацию: 4vCPU 2GHz, 8GB RAM, 60GB HDD.

Тестирование vSGA

vSGA — это технология VMware, обеспечивающая виртуализацию ресурсов GPU, установленных в сервера под управлением гипервизора VMware ESXi, и последующее использование данных GPU для обеспечения 3D ускорения для виртуальных видеокарты, выданных для виртуального сервера.

Технология обладает множеством ограничений по производительности и функционалу виртуальных видеокарт, однако позволяет максимизировать плотность виртуальных машин на один GPU.

Фактически, нам удалось запустить машины с близким к двухкратному превышением количества виртуальной видеопамяти в сравнении с количеством физической видеопамяти на используемых GPU.

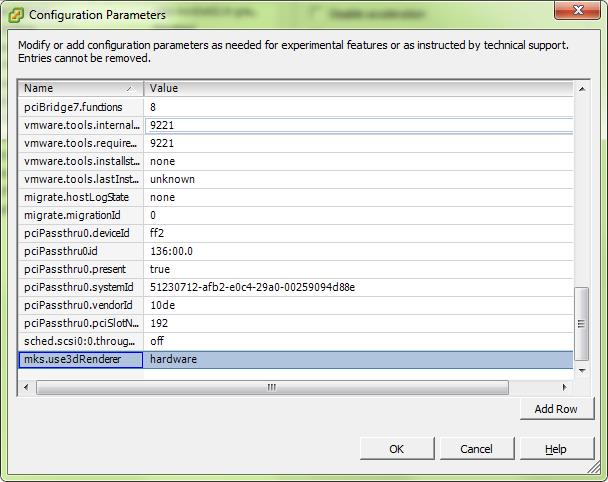

и добавить параметр mks.use3dRenderer = hardware в ее параметры:

В гостевой ОС такая виртуальная видеокарта определяется как «VMware SVGA 3D». Она отличается от обычной виртуальной видеокарты только объемом памяти и поддержкой аппаратного ускорения вышеперечисленных API.

Результаты выполнения теста FurMark на такой VDI машине однозначно говорят, что играть на ней не придется (при этом необходимо отметить, что во время тестирования физической видеокартой пользовалась одна виртуальная машина, то есть все вычислительные ресурсы видеокарты, с учетом накладных расходов виртуализации, были доступны тесту):

С точки зрения AutoCad 2014 возможности видеокарты выглядят следующим образом:

Enhanced 3D Performance: Available and on

Smooth display: Available and off

Gooch shader: Available and using hardware

Per-pixel lighting: Available and on

Full-shadow display: Available and on

Texture compression: Available and off

Advanced material effects: Available and on

Autodesk driver: Not Certified

Effect support:

Enhanced 3D Performance: Available

Smooth display: Available

Gooch shader: Available

Per-pixel lighting: Available

Full-shadow display: Available

Texture compression: Available

Advanced material effects: Available

Как видно, формально все параметры аппаратного ускорения поддерживаются драйвером. Предполагается, что проблемы с поддержкой мы можем увидеть только при использовании более тяжелых продуктов, использующих, например, архитектуру CUDA.

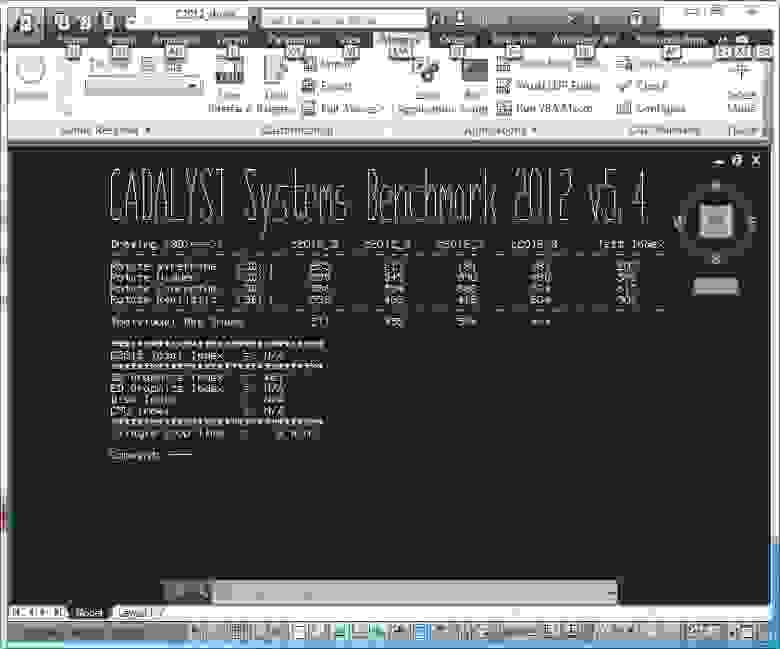

Результаты выполнения теста Cadalyst Benchmark:

Результаты не впечатляю, однако использовать данное ПО можно, а если большой производительности и работы со сложными моделями не требуется — например, в учебном классе, то высокая плотность и низкая стоимость таких машин может оказаться полезной.

Тестирование vDGA

vDGA — это название, используемое VMware для обозначения проброса физической видеокарты в виртуальную машину.

Фактически, для данной технологии NVIDIA GRID дала одно единственное преимущество — высокую плотность GPU, которая позволяет отказаться от использования внешних PCIe корзин.

Например, в используемый на тестовом стенде сервер возможно установить три видеокарты NVIDIA GRID K1, что даст нам 12 независимых ускорителей класса QUADRO K600. Это позволяет запустить на сервере 12 виртуальных серверов, что позволяет загрузить мощности сервера, а в зависимости от профиля нагрузки — и дает запас по GPU ресурсам по сравнению с CPU ресурсами.

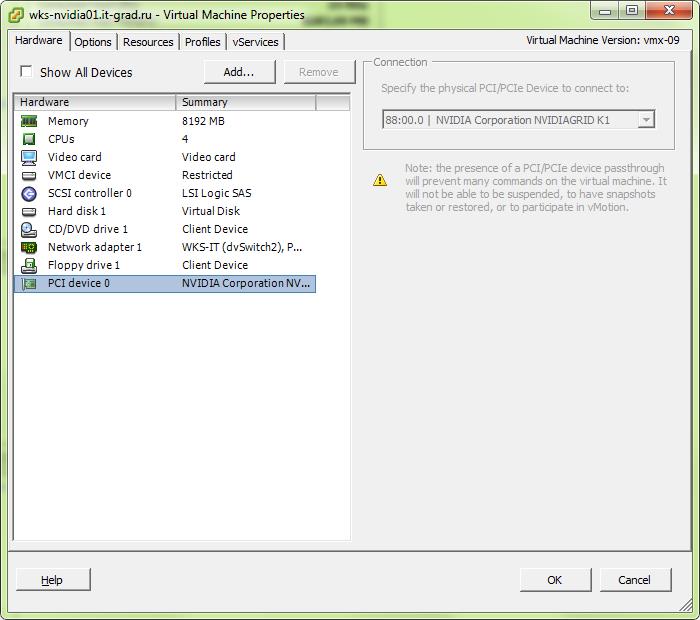

Для проброса видеокарты в виртуальный сервер необходимо включить режим passthrough для данного PCIe устройства в конфигурации хоста и добавить PCI устройство в конфигурацию виртуальной машины:

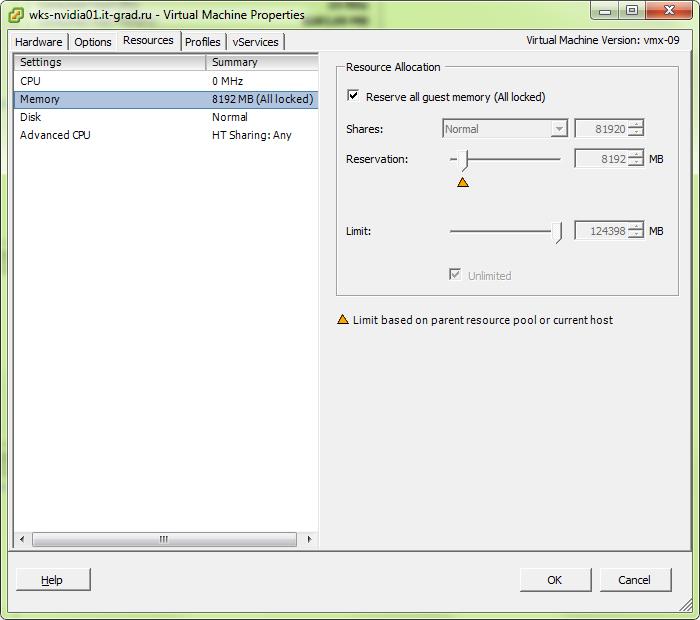

Также, требуется установить полное резервирование памяти для данной виртуальной машины

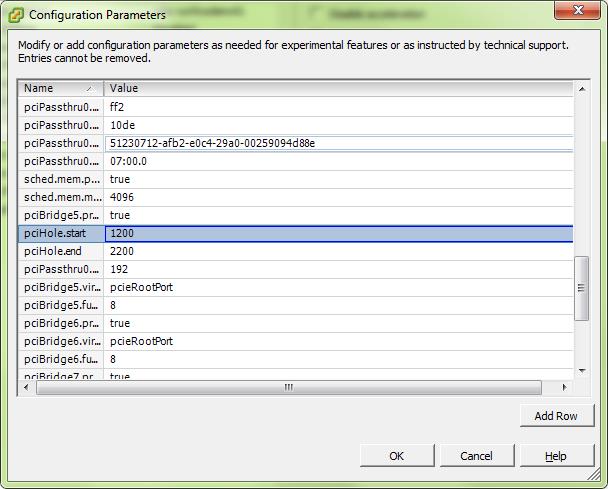

и провести настройку pci hole. На этот счет существуют различные мнения, мы выбрали значения от 1200 до 2200:

В гостевой ОС в таком случае видеокарта видится полноценным устройство от NVIDIA и требует установки драйверов для семейства видеокарт GRID.

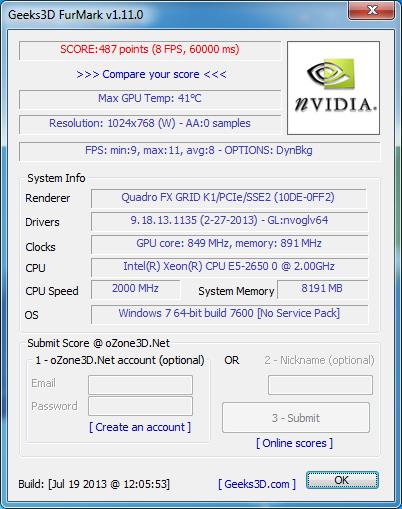

Результаты FurMark близки к результатам, полученным в тесте vSGA, что говорит об относительной эффективности уровня виртуализации для этого теста:

При использовании AutoCad 2014 картина следующая:

Current Effect Status:

Enhanced 3D Performance: Available and on Smooth display: Available and off

Gooch shader: Available and using hardware

Per-pixel lighting: Available and on

Full-shadow display: Available and on

Texture compression: Available and off

Advanced material effects: Available and on

Autodesk driver: Not Certified

Effect support:

Enhanced 3D Performance: Available

Smooth display: Available

Gooch shader: Available

Per-pixel lighting: Available

Full-shadow display: Available

Texture compression: Available

Advanced material effects: Available

Все возможности также ожидаемо поддерживаются, однако карточка не является сертифицированной. Из серии GRID для AutoCad сертифицирована только K2.

Результаты выполнения бенчмарка Cadalyst 2012:

Как мы видим, проброшенная видеокарта показывает фактически результаты в 4 раза большие, чем виртуализированная. В данном случае, использовать для работы проектировщика такую машину уже возможно.

Если же производительности карты K1 не достаточно, можно установить K2 и получить top range видеокарту внутри виртуального сервера.

Во второй части статьи

Мы подробно расскажем о возможности виртуализации GPU посредством технологий NVIDIA, которые обещают нам поддержку всех доступных физической карте API и производительность, достаточную для уверенной работы с CAD, покажем тестовый стенд, замеры производительности таких видеокарт и подведем итоги. Продолжение следует.

Виртуальная видеокарта QXL на реальном железе

QXL vs. VNC

Виртуальная видеокарта QXL изначально была разработана для использования в эмуляторе KVM для улучшения вывода графики через протокол SPICE. С недавнего времени виртуальная видеокарта QXL может использоваться на реальном оборудовании для предоставления удаленного доступа по сети по протоколу SPICE к экрану сервера под управлением X-сервера, как альтернатива VNC-серверу.

Для запуска VNC-сервера нужен X-сервер, который должен быть запущен локально и которому для работы нужна видеокарта. В отличие от VNC-сервера, SPICE-сервер встроен в драйвер виртуальной видеокарты QXL, а как следствие может запускать X-сервер без наличия реальной видеокарты.

Работа с компьютером без использования видеокарты может использоваться не только для снижения стоимости конфигурации и использования, но также и для проброса всех установленных PCI-видеокарт в виртуальные машины спомощью технологий Vt-d и IOMMU.

Установка и настройка

В качестве примера проведем эксперимент по настройке удаленного доступа через SPICE-сервер на виртуальных машинах под управлением Ubuntu 12.04 и Fedora 17 после настройки из которых удалим видеоакарты. Если эксперимент с виртуальными машинами у Вас удастся можно переходить к реальному железу.

Прежде чем приступить к эксперименту, на компьютерах под управлением операционной системы GNU/Linux семейства Ubuntu 12.04 далее (Ubuntu) подключаем репозиторий repo.umvirt.org:

Внимание: в настоящее время в репозитории представлены пакеты только для платформы amd64!

На компьютерах под управлением Fedora17 (далее Fedora) подключать репозиторий не нужно. Другие версии и дистрибутивы не тестировались.

vGPU — использовать нельзя игнорировать

За июнь-июль к нам обратилось почти два десятка компаний, интересовавшихся возможностями виртуальных GPU. «Графикой» от Cloud4Y уже пользуется одна из крупных «дочек» Сбербанка, но в целом услуга не слишком популярная. Так что подобная активность нас весьма порадовала. Видя рост интереса к технологии, мы решили чуть подробнее рассказать про vGPU.

«Озёра данных», полученные в результате научных экспериментов и исследований, Deep Learning и другие направления работы с ИИ, моделирование крупных и сложных объектов — всё это требует высокопроизводительного «железа». Хорошо, если оно есть и позволяет быстро решать текущие задачи. Вот только из-за возрастающей вычислительной сложности задач (в первую очередь касается для бизнес-аналитики, рендеринга, DL-алгоритмов и фреймворков) аппаратные мощности настольных и даже серверных CPU всё чаще становятся бесполезны.

Выход был найден в использовании вычислений на GPU. Эта технология ускорения графики обеспечивает разделение ресурсов одного графического процессора между несколькими виртуальными компьютерами. GPU изначально проектировался для работы с графикой, потому состоит из тысячи мелких ядер, используемых для эффективной обработки параллельных задач. При этом на GPU выполняется часть самых ресурсоемких вычислений, остальное берёт на себя CPU.

Вычисления с помощью GPU придумала компания Nvidia ещё в 2007 году. Сегодня эта технология вышла на новый уровень и применяется в ЦОДах крупнейших предприятий и научных лабораторий. Однако у традиционного подхода есть один весомый недостаток: закупка физического оборудования обходится весьма недёшево. А если вспомнить скорость устаревания «железа», то становится ещё грустнее.

Проблему призвана решить технология виртуальных графических процессоров: vGPU. С её помощью пользователи могут удалённо запускать тяжёлые приложения вроде AutoCAD, 3DS Max, Maya, Sony Vegas Pro. Виртуализация быстро отвоевала свою долю рынка. Ведь какой русский data-scientist не любит быстрых вычислений на видеокартах NVidia Tesla?

Здесь стоит отметить, что до появления vGPU использовались другие методы ускорения обработки графики: Virtual Shared Graphics Acceleration (vSGA) и Virtual Dedicated Graphics Acceleration (vDGA). Решение vGPU объединило лучшее из обеих технологий. Как и в случае vSGA, в среде vGPU предполагается совместное использование GPU и RAM несколькими виртуальными рабочими столами, но при этом каждая ВМ передаёт команды напрямую к GPU, как в случае с vDGA.

Зачем вообще нужны vGPU

Облачные вычисления с использованием vGPU позволяют компаниям справляться с задачами, которые раньше невозможно было решить. Или возможно, но для этого требовалось нереально много ресурсов. 1 современный GPU-сервер способен заменить до 100 обычных CPU. Есть и другие, ещё более внушительные цифры. Это не шутки: решения Nvidia обрабатывают петабайты данных в несколько раз быстрее классических CPU-серверов. А тот же Google Cloud предлагает виртуальные машины с GPU, выдающие до 960 терафлопс.

Многие специалисты нуждаются в мощных устройствах, способных выполнять параллельные вычисления. Архитекторы и инженеры используют технологию vGPU в системах проектирования (тот же Autodesk, к примеру). Дизайнеры работают с цифровым фото- и видеоконтентом (Photoshop, CorelDraw). Виртуальные машины с графическими процессорами требуются и медицинским учреждениям, которые аккумулируют и анализируют данных о пациентах и заболеваниях. Работает с GPU и «Яндекс».

При всём при этом решения на базе vGPU пока что не получили широкого распространения в мире. Так, в 2018 году NetApp провёл опрос среди компаний, использующих в работе графические процессоры. Результаты показали, что 60% организаций по-прежнему работают на собственной ИТ-инфраструктуре. «Облаком» же пользуются лишь 23%. В России проникновение технологии облачных вычислений имеет меньшее значение. Но благодаря новым аппаратным и программным решениям число компаний, использующих виртуальные машины с GPU, постоянно растёт.

Решения для vGPU

Разработкой технологий виртуализации графических ускорителей занимается много компаний, но среди них есть безусловные лидеры.

Один из наиболее авторитетных разработчиков решений в сфере облачных решений, компания VMware предлагает компаниям гипервизор ESXi, под которым скорость работы виртуальных графических процессоров сопоставима с реализациями на голом железе. В недавнем обновлении разработчик отключил балансировщик нагрузки vMotion и добавил поддержку технологии DirectPath I/O, которая связывает драйвер CUDA с ВМ в обход гипервизора и ускоряет передачу данных.

Nvidia тоже старается соответствовать ожиданиям рынка, и для этого выпустила opensource-платформу Rapids. Решение объединяет несколько библиотек для работы с архитектурой CUDA, что упрощает работу с данными во время тренировки нейросетей и позволяет автоматизировать работу с Python-кодом. Использование Rapids с алгоритмом машинного обучения XGBoost даёт 50-кратное увеличение производительности по сравнению с системами на базе CPU.

Своя технология есть и у AMD. Платформа называется ROCm. Она использует технологию SR-IOV, которая делит аппаратные возможности физического устройства между несколькими виртуальными машинами. Ресурсы одного ускорителя можно разделить между шестнадцатью пользователями, поддерживая равную производительность для каждого из них. Таким образом ускоряется передача данных между облачными CPU и GPU. Также используется специальный диалект C++ под названием HIP, который упрощает выполнение математических операций на GPU.

Intel строит свою технологию базе кросс-платформенного гипервизора Citrix XenServer 7, который в 2017 году получил сертификат соответствия ФСТЭК. Решение объединяет работу стандартного GPU-драйвера и виртуальной машины. То есть «виртуалка» может поддерживать работу тяжёлых приложений на устройствах большого (несколько сотен) количества пользователей.

Рыночные перспективы

Независимые аналитики считают, что объём продаж решений для HPC-систем достигнет 45 млрд долларов к 2022 году. Разработчики платформ также ожидают увеличения спроса на высокопроизводительные системы. Это ожидание подкрепляется популярностью Big Data и часто возникающей необходимостью обрабатывать крупные объёмы данных.

Также рост спроса на vGPU может стимулировать развитие гибридных технологий, объединяющих GPU и CPU в одном устройстве. В таких интегрированных решениях два вида ядер используют общий кэш, что ускоряет перенос данных между графическими и традиционными процессорами.

Гибриды в корне изменили подход к виртуализации и распределению виртуальных ресурсов в рамках дата-центров. А решения с открытым исходным кодом наподобие ROCm и Rapids позволяют операторам ЦОД эффективнее использовать вычислительные ресурсы, повышая производительность оборудования.

Есть и другое мнение. Например, что виртуальные GPU будут вытеснены оптическими чипами с фотонным кодированием данных. Такие решения уже существуют и используются для машинного обучения. Более того, они кажутся производительнее обычного GPU. Но технология ещё сыровата.

Какой можно сделать вывод? Несмотря на возможное появление аналогов, vGPU — вполне перспективное направление, способное решать большое количество задач. Но подходит оно не всем. Так что запятую в заголовке можете поставить сами.