веб краулер что это

5 способов краулинга веб-сайта

Из Википедии веб-краулер или паук – бот, который с просматривает всемирную паутину, как правило, с целью индексации. Поисковики и другие веб-сайты используют краулеры для обновления своего содержимого или индексации содержимого других сайтов.

Metasploit

Вспомогательный поисковый модуль Metasploit представляет собой модульный поисковый робот, который будет использоваться вместе с wmap или автономно.

Видно, что был запущен сканер, с помощью которого можно найти скрытые файлы на любом веб-сайте, например:

Что невозможно сделать вручную при помощи браузера.

Httrack

HTTrack — это бесплатный краулер и автономный браузер с открытым исходным кодом. Он позволяет полностью скачать веб-сайт, рекурсивно строя все каталоги

получая:

HTTrack упорядочивает относительную структуру ссылок исходного сайта.

Введем следующую команду внутри терминала

Он сохранит вывод в заданном каталоге /root/Desktop/file

На скриншоте можно увидеть, что Httrack скачал немало информации о веб-сайте, среди которой много:

Black Widow

Представляет собой загрузчик веб-сайтов и офлайн браузер. Обнаруживает и отображает подробную информацию для выбранной пользователем веб-страницы. Понятный интерфейс BlackWidow с логическими вкладками достаточно прост, но обилие скрытых возможностей может удивить даже опытных пользователей. Просто введите желаемый URL и нажмите Go. BlackWidow использует многопоточность для быстрой загрузки всех файлов и проверки ссылок. Для небольших веб-сайтов операция занимает всего несколько минут.

Введем свой URL http://tptl.in в поле адрес и нажмем «Go».

Нажимаем кнопку «Start», расположенную слева, чтобы начать сканирование URL-адресов, а также выбираем папку для сохранения выходного файла. На скриншоте видно, что просматривался каталог C:\Users\RAJ\Desktop\tptl, чтобы сохранить в нем выходной файл.

В каталоге tptl теперь будут храниться все данные веб-сайта:

Website Ripper Copier

Website Ripper Copier (WRC) — это универсальная высокоскоростная программа-загрузчик веб-сайтов. WRC может загружать файлы веб-сайтов на локальный диск для просмотра в автономном режиме, извлекать файлы веб-сайтов определенного размера и типа, такие как:

Также WRC может извлекать большое количество файлов в качестве диспетчера загрузки с поддержкой возобновления.

Вдобавок WRC является средством проверки ссылок на сайты, проводником и веб-браузером с вкладками, предотвращающим всплывающие окна. Website Ripper Copier — единственный инструмент для загрузки веб-сайтов, который может:

Выбираем «websites for offline browsing».

Вводим URL-адрес веб-сайта как http://tptl.in и нажимаем «next».

Указываем путь к каталогу, чтобы сохранить результат, после чего жмём «run now».

При открытии выбранного каталога tp, внутри него будут файлы:

Burp Suite Spider

Burp Suite Spider – это инструмент для автоматического сканирования веб-приложений, более подробно о котором уже писали на habr. В большинстве случаев желательно отображать приложения вручную, но с помощью Burp Spider данный процесс можно автоматизировать, что упростит работу с очень большими приложениями или при нехватке времени.

На скриншоте видно, что http-запрос был отправлен «пауку» с помощью контекстного меню.

Веб-сайт был добавлен на карту сайта под целевой вкладкой в качестве новой области для веб-сканирования, в результате которого была собрана информация в форме:

Пишем краулер на раз-два 1.0

Веб-краулер (или веб-паук) — это важная составная часть поисковых систем для обхода веб-страниц с целью занесения информации о них в базы данных, в основном, для их дальнейшей индексации. Такая штука есть у поисковиков (Google, Yandex, Bing), а также у SEO-продуктов (SEMrush, MOZ, ahrefs) и не только. И штука эта — довольно интересная: как в плане потенциала и вариантов использования, так и для технической реализации.

Этой статьей мы начнем итеративно создавать свой велосипед краулер, разбирая многие особенности и встречая подводные камни. От простой рекурсивной функции до масштабируемого и расширяемого сервиса. Должно быть интересно!

Интро

Итеративно — значит в конце каждого выпуска ожидается готовая к использованию версия «продукта» с условленными ограничениями, характеристиками и интерфейсом.

В качестве платформы и языка выбраны node.js и JavaScript, потому что это просто и асинхронно. Конечно, для промышленной разработки выбор технологической базы должен опираться на бизнес-требования, ожидания и ресурсы. В качестве же демонстрации и прототипа эта платформа — вполне ничего (имхо).

Это мой краулер. Таких краулеров много, но этот — мой.

Мой краулер — мой лучший друг.

Реализация краулера — довольно популярная задача и встречается даже на технических собеседованиях. Готовых (Apache Nutch) и самописных решений для разных условий и на множестве языков — действительно много. Поэтому, любые комментарии из личного опыта разработки или использования приветствуются и будут интересны.

Постановка задачи

Задание для первой (начальной) реализации нашего тяп-ляп краулера будет следующим:

Краулер на раз-два 1.0

Написать краулер-скрипт, который обходит внутренние ссылки некоторого небольшого (до 100 страниц) сайта. В качестве результата предоставить список URL’ов страниц с полученными кодами и карту их перелинковки. Правила robots.txt и атрибут ссылки rel=nofollow игнорировать.

Внимание! Игнорировать правила robots.txt — плохая идея по понятным причинам. Мы наверстаем это упущение в дальнейшем. А пока, добавим ограничивающий количество обходимых страниц параметр limit, чтобы останавливаться и не DoS’ить подопытный сайт (лучше и вовсе для экспериментов использовать какой-нибудь свой персональный «сайт-хомячок»).

Реализация

Для нетерпеливых вот исходники этого решения.

1. HTTP(S)-клиент

Первое, что нам нужно уметь делать — это, собственно, отправлять запросы и получать ответы по HTTP и HTTPS. В node.js для этого есть два соответствующих клиента. Конечно, можно взять готовый клиент request, но для нашей задачи он крайне избыточен: нам всего лишь надо отправить GET-запрос и получить response с телом и заголовками.

Необходимый нам API обоих клиентов идентичен, заведем мапу:

Объявим простую функцию fetch, единственным параметром которой будет абсолютный URL нужного веб-ресурса строкой. С помощью утильного модуля url будем парсить полученную строку в объект URL. В этом объекте имеется поле с протоколом (с двоеточием), по которому мы выберем подходящий клиент:

Далее используем выбранный клиент и обернем результат функции fetch в промис:

Теперь мы умеем асинхронно получать response, но пока ничего с ним не делаем.

2. Варианты ответа

Для обхода сайта достаточно обрабатывать 3 варианта ответа:

Реализация стратегии формирования результата в лучших традициях if-else:

Функция fetch готова к использованию: код функции целиком.

3. Экстрагирование ссылок

Теперь в зависимости от варианта полученного ответа нужно уметь экстрагировать из данных результата fetch ссылки для дальнейшего обхода. Для этого определим функцию extract, принимающую на вход объект результата и возвращающую массив новых ссылок.

Если тип результата — REDIRECT, то функция вернет массив с одной единственной ссылкой из поля location. Если NO_DATA, то пустой массив. Если же OK, то нам необходимо подключить парсер для представленного текстового content для поиска.

Для задачи поиска можно написать и регулярное выражение. Но это решение совершенно не масштабируется, так как в дальнейшем мы как минимум будем обращать внимание на прочие атрибуты (rel) ссылки, как максимум — подумаем про img, link, script, audio/video (source) и прочие ресурсы. Гораздо перспективнее и удобнее парсить текст документа и строить дерево его узлов для обхода привычными селекторами.

Воспользуемся популярной библиотекой JSDOM для работы с DOM в node.js:

Достаем из документа все A элементы, а затем все отфильтрованные значения атрибута href, как не пустые строки.

4. Подготовка и фильтрация ссылок

В результате работы экстрактора мы имеем набор ссылок (URL) и две проблемы: 1) URL может быть относительным и 2) URL может вести на внешний ресурс (нам нужны сейчас только внутренние).

С первой проблемой нам поможет справиться функция url.resolve, которая резолвит URL целевой страницы относительно URL страницы-источника.

Чтобы решить вторую проблему, напишем простую утильную функцию inScope, которая проверяет хост целевой страницы относительно хоста базового URL текущего краула:

Функция осуществляет поиск подстроки (baseHost) с проверкой предыдущего символа, если подстрока была найдена: так как wwwexample.com и example.com — разные домены. В результаты мы не покидаем заданный домен, но обходим его поддомены.

Доработаем функцию extract, добавив «абсолютизацию» и фильтрацию полученных ссылок:

Здесь fetched — полученный результат от функции fetch, src — URL страницы-источника, base — базовый URL краула. На выходе мы получаем список уже абсолютных внутренних ссылок (URL) для дальнейшей обработки. Код функции целиком можно увидеть здесь.

5. Нормализация URL

Повторно встретив какой-либо URL, не нужно отправлять еще запрос за ресурсом, так как данные уже были получены (или другое соединение еще открыто и ожидает ответа). Но не всегда достаточно сравнить строки двух URL, чтобы это понять. Нормализация — это процедура, необходимая для определения эквивалентности синтаксически различных URL-адресов.

Процесс нормализации — это целый набор преобразований, применяемых к исходному URL и его компонентам. Вот только некоторые из них:

Да, здесь нет сортировки query-параметров, игнорирования utm-меток, обработки _escaped_fragment_ и прочего, чего нам (пока) совершенно не нужно.

Далее заведем локальный кэш запрошенных в рамках краула нормализованных URL. Перед отправкой очередного запроса нормализуем полученный URL, и, если тот отсутствует в кэше, добавим и только тогда отправим новый запрос.

6. Алгоритм работы main-функции

Ключевые компоненты (примитивы) решения уже готовы, пришло время начать собирать все вместе. Для начала определимся с сигнатурой функции crawl: на входе — стартовый URL и ограничение по страницам. Функция возвращает промис, резолв которого предоставляет аккумулированный результат; запишем его в файл output:

Простейшая схема рекурсивной работы функции краула может быть описана шагами:

1. Инициализация кэша и объекта результата

2. ЕСЛИ URL целевой страницы (через normalize) отсутствует в кэше, ТО

— 2.1. ЕСЛИ достигнут limit, ТО КОНЕЦ (ждать результат)

— 2.2. Добавить URL в кэш

— 2.3. Сохранить ссылку между источником и целевой страницей в результат

— 2.4. Отправить асинхронный запрос за страницей (fetch)

— 2.5. ЕСЛИ запрос выполнился успешно, ТО

— — 2.5.1. Экстрагировать новые ссылки из результата (extract)

— — 2.5.2. Для каждой новой ссылки выполнить алгоритм 2-3

— 2.6. ИНАЧЕ пометить страницу состоянием ошибки

— 2.7. Сохранить данные о странице в результат

— 2.8. ЕСЛИ это была последняя страница, ТО ВЕРНУТЬ результат

3. ИНАЧЕ сохранить ссылку между источником и целевой страницей в результат

Да, этот алгоритм будет претерпевать серьезные изменения в дальнейшем. Сейчас же умышленно используется рекурсивное решение в лоб, чтобы позже лучше «прочувствовать» разницу в реализациях. Заготовка для имплементации функции выглядит так:

Достижение лимита страниц проверяется простым счетчиком запросов. Второй счетчик — количество активных запросов в момент времени — послужит проверкой готовности отдать результат (когда значение оборачивается в ноль). Если функции fetch не удалось получить очередную страницу, то для нее Status Code выставим как null.

С кодом имплементации можно (не обязательно) ознакомиться здесь, но перед этим стоит рассмотреть формат возвращаемого результата.

7. Возвращаемый результат

Введем уникальный идентификатор id с простым инкрементом для опрошенных страниц:

Для результата заведем массив pages, в который будем складывать объекты с данными по странице: id

Для информативности перед резолвом результата отсортируем список страниц по возрастанию id (ведь ответы будут приходить в каком-угодно порядке), дополним результат числом просканированных страниц count и флагом о достижении заданного лимита fin:

Пример использования

Готовый краулер-скрипт имеет следующий синопсис:

Дополнив логированием ключевых точек процесса, увидим такую картину при запуске:

А вот результат в формате JSON:

Что с этим уже можно делать? Как минимум, по списку страниц можно найти все битые страницы сайта. А имея информацию о внутренней перелинковке, можно обнаружить длинные цепочки (и замкнутые циклы) редиректов или найти наиболее важные страницы по ссылочной массе.

Анонс 2.0

У нас получился вариант простейшего консольного краулера, который обходит страницы одного сайта. Исходный код лежит здесь. Там же есть еще пример и юнит-тесты для некоторых функций.

10 перспективных поисковых роботов для улучшения SEO

Выполните тщательную SEO проверку своего сайта для улучшения ранжирования в поиске.

Поисковая оптимизация — это непрерывный процесс улучшений, существует множество онлайн-инструментов для анализа вашего сайта и предоставления необходимой информации, с которых хорошо начинать этот процесс.

Однако, если вам необходимо более детально изучить различные элементы SEO, тогда стоит рассмотреть возможность использования более продвинутых, комплексных инструментов.

Что такое веб-краулер?

Краулер – это программа/скрипт, позволяющий автоматически просматривать сайт. Его еще называют веб-паук или веб-робот. Многие известные сайты используют спайдеринг как средство предоставления актуальных данных.

Выгоды от использования поискового робота:

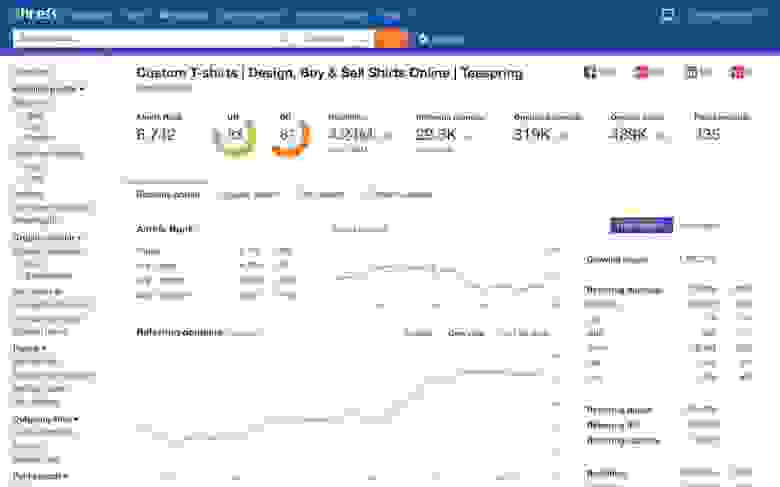

Ahrefs

Ahrefs – это хорошо известный инструмент SEO, который предоставляет лучшие и очень точные данные для профессионалов цифрового маркетинга.

По сравнению с другими инструментами он имеет наиболее значимый индекс обратных ссылок. Используя этот инструмент, вы можете проверить SEO своих конкурентов и улучшить свои стратегии.

Давайте посмотрим на некоторые показатели Ahrefs:

Свойства

SEMrush

Комплексное маркетинговое программное обеспечение, которое предназначено исключительно для SEO, анализа социальных сетей, трафика и контента.

SEMrush — это программа, которую используют все блоггеры для оптимизации своих сайтов и создания благоприятного впечатления на пользователей. Она может помочь вам извлечь максимальную выгоду от своего сайта с помощью таргетирования по ключевым словам и очень полезного анализа конкурентов вплоть до их обратных ссылок.

Свойства

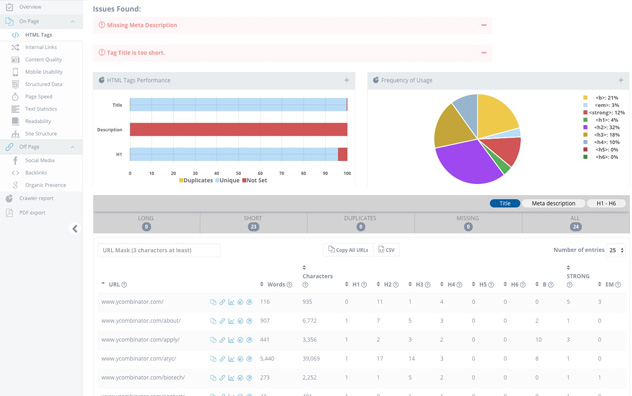

SEO Spider

Spider от Screaming Frog – это скачиваемое программное обеспечение для macOS, Windows, Ubuntu, доступное как в бесплатной, так и в платной версии.

Бесплатная версия может обрабатывать не более 500 страниц.

Свойства

Sitebulb

Sitebulb совмещает высококачественный анализ и визуализацию данных. Это удобное для пользователей приложение на Windows и Mac.

Пользователям больше не нужно беспокоиться о нестандартных электронных таблицах или дорогостоящих программных продуктах.

Свойства

Seomator

Seomator — это инструмент для мониторинга и аудита как технических, так и архитектурных характеристик веб-сайта, отправляющий после проверки полный аналитический отчет на вашу почту и указывающий при этом области, нуждающиеся в улучшении.

Он принимает во внимание внешнюю и внутреннюю оптимизацию, характеристики скорости загрузки сайта, удобство использования на мобильных устройствах и качество контента, а затем предоставляет все эти данные в консолидированном и структурированном отчете.

Свойства

DeepCrawl

DeepCrawl — это управляемый облачный краулер, который помогает анализировать ваш сайт, понимать технические причины для повышения эффективности SEO.

Свойства

OnCrawl

OnCrawl — это поисковый робот, работающий через веб-интерфейс и анализирующий логи для качественного аудита и ежедневного мониторинга.

Он предоставляет подробную картину влияния SEO на различные атрибуты веб-сайта. Пользовательский интерфейс довольно привлекательный и формирует понятное представление о многих вещах.

Свойства

Raventool

Raventool предназначен для управления SEO и рекламными кампаниями.

С помощью этого инструмента ваша организация может моментально проводить исследования и анализ, отслеживать поисковые системы и сотрудничать с другими членами команды.

Свойства

Serpstat

Комплексный раразвивающийся инструмент для PPC, контент-маркетинга и SEO. Serpstat предоставляет все необходимое усовершенствования развития.

Serpstat также предлагает API для отслеживания местоположения, ключевых слов и др.

Список не будет полным, если не включить в него Moz.

Это один из популярных инструментов SEO для проведения исследований, оптимизации, совершенствования и проверки.

Moz предлагает 30-дневную пробную версию.

Заключение

Выбор краулера сводится к задаче нахождения наиболее подходящего инструмента именно для вашей работы и в рамках вашего бюджета. Большинство из перечисленных сервисов предлагают несколько бесплатных дней для того, чтобы изучить их и понять, подходят ли они вам.

Что такое краулинг и как управлять роботами

Выдача ответов на поисковый запрос на странице поиска за долю секунды только верхушка айсберга. В «черном ящике» поисковых систем — просканированные и занесенные в специальную базу данных миллиарды страниц, которые отбираются для представления с учетом множества факторов.

Страница с результатами поиска формируется в результате трех процессов:

В этом выпуске «Азбуки SEO» речь пойдет о сканировании или краулинге страниц сайта.

Как работает сканирование (краулинг) сайта?

Если кратко, краулинг (сканирование, crawling) — процесс обнаружения и сбора поисковым роботом (краулером) новых и обновленные страницы для добавления в индекс поисковых систем. Сканирование — начальный этап, данные собираются только для дальнейшей внутренней обработки (построения индекса) и не отображаются в результатах поиска. Просканированная страница не всегда оказывается проиндексированной.

Поисковый робот (он же crawler, краулер, паук, бот) — программа для сбора контента в интернете. Краулер состоит из множества компьютеров, запрашивающих и выбирающих страницы намного быстрее, чем пользователь с помощью своего веб-браузера. Фактически он может запрашивать тысячи разных страниц одновременно.

Что еще делает робот-краулер:

При сканировании пауки просматривают страницы и выполняют переход по содержащимся на них ссылкам так же, как и обычные пользователи. При этом разный контент исследуется ботами в разной последовательности. Это позволяет одновременно обрабатывать огромные массивы данных.

Например, в Google существуют роботы для обработки разного типа контента:

В статье о robots.txt мы собрали полный перечень роботов-пауков. Знакомьтесь 🙂

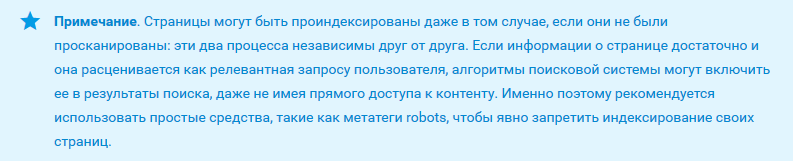

Кстати, именно с robots.txt и начинается процесс сканирования сайта — краулер пытается обнаружить ограничения доступа к контенту и ссылку на карту сайта (Sitemap). В карте сайта должны находиться ссылки на важные страницы сайта. В некоторых случаях поисковый робот может проигнорировать этот документ и страницы попадут в индекс, поэтому конфиденциальную информацию нужно закрывать паролем непосредственно на сервере.

Просматривая сайты, бот находит на каждой странице ссылки и добавляет их в свою базу. Робот может обнаружить ваш сайт даже без размещения ссылок на него на сторонних ресурсах. Для этого нужно осуществить переход по ссылке с вашего сервера на другой. Заголовок HTTP-запроса клиента «referer» будет содержать URL источника запроса и, скорее всего, сохранится в журнале источников ссылок на целевом сервере. Следовательно, станет доступным для робота.

Поисковой паук (краулер): виды и функции

Поисковый паук (другие наименования — робот, веб-паук, краулер) — программа поисковой системы, сканирующая веб-ресурсы для отражения сведений о них в базе данных.

С какой целью создают поисковых пауков?

Приведём элементарный пример. Представим себе Иванова Валерия, который регулярно посещает сайт http://it-ebooks.info/, где ежедневно публикуются новые электронные книги. Заходя на ресурс, Валерий выполняет заданную последовательность действий:

1) открывает главную страницу;

2) заходит в раздел «Последние загруженные произведения»;

3) оценивает новинки из списка;

4) при появлении интересных заголовков, проходит по ссылкам;

5) читает аннотацию и, если она интересна, скачивает файл.

Указанные действия отнимают у Валерия 10 минут. Однако, если тратить на поиск 10 минут в день, в месяц это уже 5 часов. Вместо этого к задаче можно привлечь программу, отслеживающую новинки по расписанию. По механизму действия она будет представлять собой простейшего веб-паука, заточенного под выполнение определенных функций. Без краулеров не выживет никакая поисковая система, будь то лидеры Google и «Яндекс» или предприимчивые стартапы. Боты перемещаются по сайтам, отыскивая сырье для поисковой системы. При этом чем с большей отдачей трудится паук, тем актуальнее результаты выдачи (рис. 1).

В зависимости от поисковой системы, функции, которые мы перечислим ниже, могут выполнять один или несколько роботов.

1. Сканирование контента сайта. Функция краулера первого порядка — обнаружение вновь созданных страниц и сбор размещенной текстовой информации.

2. Считывание графики. Если поисковая система подразумевает поиск графических файлов, для этой цели может быть введен отдельный веб-паук.

3. Сканирование зеркал. Робот находит идентичные по содержанию, но разные по адресу, ресурсы. «Работник», наделенный такими должностными полномочиями, есть у «Яндекса».

Содержание

Виды поисковый роботов

У поисковых систем есть несколько пауков, каждый из которых поддерживает выполнение запрограммированных функций (рис. 2).

Пауки «Яндекс»

Пауки Google

Вежливые пауки — как научить роботов правилам поведения

Вежливыми называют краулеров, которые действуют, придерживаясь существующих правил поведения на сайте. Эти правила пишут вебмастеры, размещая их в файле robots.txt (рис. 3). Пауки, которые попадают на сайт, на начальном этапе изучают информацию в указанном файле, где перечислены страницы, содержание которых не подлежит разглашению (регистрационные данные пользователей, административные сведения). Получив указания, паук приступает к индексации сайта, либо покидает его.

В robots.txt прописывают:

User-Agent: Twitterbot Allow: /images

Расшифруем эти данные:

Вежливый робот всегда представляется и указывает в заголовке запроса реквизиты, которые дают возможность вебмастеру связаться с владельцем. Для чего вводятся ограничения? Владельцы ресурсов заинтересованы в привлечении реальных пользователей и не желают, чтобы программы строили на их контенте свой бизнес. Для этих целей сайты часто настраивают на обслуживание браузерных HTTP-запросов и лишь за тем — запросов от программ.

.jpg/200px-%D0%A1%D0%BA%D1%80%D0%B8%D0%BD%D1%88%D0%BE%D1%82_1_(24).jpg)

.jpg/200px-%D0%A1%D0%BA%D1%80%D0%B8%D0%BD%D1%88%D0%BE%D1%82_2_(17).jpg)

.jpg/200px-%D0%A1%D0%BA%D1%80%D0%B8%D0%BD%D1%88%D0%BE%D1%82_3_(13).jpg)