в чем разница между gddr6 и gddr6x

Micron представила память GDDR6X со скоростью до 21 Гбит/с. Она используется в новых GeForce RTX

Компания Micron представила, как она сама утверждает, самую быструю память для графических ускорителей — GDDR6X. Эта память способна обеспечивать пропускную способность до 1 Тбайт/с. Она дебютировала в представленных вчера NVIDIA видеокартах GeForce RTX 3080 и RTX 3090.

GDDR6X от Micron использует инновационную технологию передачи сигналов — четырёхуровневую амплитудно-импульсную модуляцию (PAM4), которая обеспечивает более высокую пропускную способность, чем у предыдущих поколений памяти.

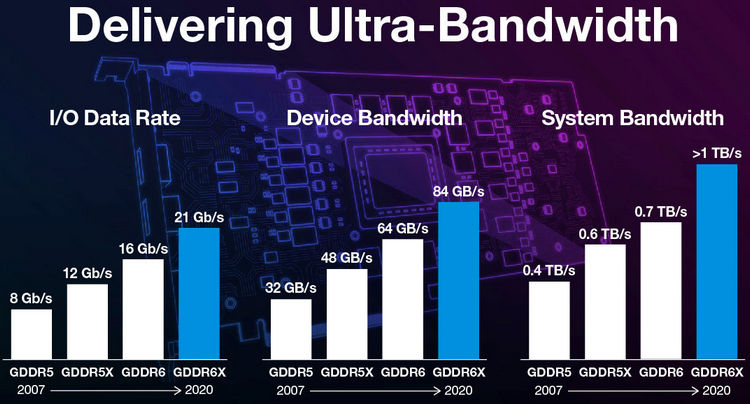

Скорость передачи данных для одного контакта GDDR6X достигает 21 Гбит/с, тогда как у GDDR6 этот показатель составлял лишь 16 Гбит/с. В результате пропускная способность всей подсистемы памяти раньше (имеется в виду с GDDR6) могла достигать лишь порядка 700 Гбайт/с, а теперь этот показатель теоретически может доходить до 1 Тбайт/с.

Нужно отметить, что утверждение производителя про самую быструю память для видеокарт справедливо лишь отчасти. GDDR6X действительно является самой быстрой среди классических типов памяти, как это описано абзацем выше. Но в то же время память HBM2 обеспечивала реальную пропускную способность в 1 Тбайт/с видеокарте Radeon VII ещё в начале 2019 года.

Тем не менее, это не умаляет достоинств новой памяти GDDR6X. По словам Micron, огромная пропускная способность этой памяти обеспечит значительные преимущества в 3D-рендеринге, играх, задачах искусственного интеллекта, научных, инженерных и финансовых вычислениях. Во всех этих случаях происходит обслуживание огромного количества данных, и чем выше пропускная способность памяти, тем быстрее эти данные можно обработать.

Чем отличаются поколения видеопамяти

Содержание

Содержание

Память, будь то оперативная память или видеопамять, является неотъемлемой частью современного компьютера. Сегодня вкратце узнаем, как все начиналось, как работает, почему диагностические программы показывают неверные частоты, в чем измеряется производительность памяти, как рассчитывается пропускная способность памяти и почему «МГц» для памяти — некорректное выражение.

До 2000-ых годов использовалась оперативная память стандарта SDR.

Потом ей на смену пришел новый стандарт памяти — DDR, который имел удвоенную пропускную способность памяти за счет передачи данных как по восходящим, так и по нисходящим фронтам тактового сигнала. Первоначально память такого типа, как и SDR, применялась в видеоплатах, но позднее появилась поддержка со стороны чипсетов.

DDR (Double Data Rate) расшифровывается как «удвоенная скорость передачи данных».

Таким образом, за один такт передается вдвое больше информации. Увеличилось количество передаваемой информации, реальная частота памяти осталась неизменной. Вместе с этим появилось такие понятия как эффективная частота, которая стала в два раза больше реальной.

Именно с приходом стандарта DDR появилась путаница с реальной и эффективной частотой работы памяти.

Реальная частота — частота шины модуля памяти. Эффективная частота — удвоенная частота шины модуля.

Как можно видеть, реальная частота памяти составляет 1900 МГц, в то время как эффективная в 2 раза больше — 3800 МГц, потому что за один такт теперь поступает вдвое больше данных.

Для того чтобы информация передавалась с удвоенной скоростью, она должна поступать из массива памяти вдвое быстрее. Реализовали это с помощью удвоения внутренней ширины модуля памяти. Благодаря чему за одну команду чтения мы стали получать сразу 2n единицы данных. Для стандарта DDR n = 1. Такая архитектура была названа n-prefetch (предвыборка). У памяти стандарта DDR, одной командой, при чтении, передается от ядра к буферу ввода-вывода две единицы данных.

Вместе с ростом производительности уменьшилось рабочее напряжение с 3.3V у SDR до 2.5V у DDR. Это позволило снизить энергопотребление и температуру, что дало возможность повысить рабочие частоты. На самом деле, потребление и, как следствие, нагрев, — это одна из самых больших проблем оперативной памяти того времени. При полном чтении всего модуля объемом 2 Гбайта память потребляет до 25 Ватт.

Оперативная память стандарта DDR2 пришла на смену стандарту DDR в 2003 году, правда, поддерживающие ее чипсеты появились годом позже. Основное отличие DDR2 от DDR заключается в увеличенной вдвое частоте работы внутренней шины, по которой данные поступают в буфер «ввод-вывод». Передача на внутреннюю шину теперь осуществляется по технологии (4n-Prefetch), одной командой из массива памяти к буферу поступает 4 единицы данных.

Таким способом удалось поднять пропускную способность в два раза, не увеличивая частоту работы чипов памяти. Это выгодно с точки зрения энергоэффективности, да и количество годных чипов, способных работать на меньшей частоте, всегда больше. Однако у данного способа увеличения производительности есть и минусы: при одинаковой частоте работы DDR2 и DDR временные задержки у DDR2 будут значительно выше, компенсировать которые можно только на более высоких частотах работы.

Рабочее напряжение понизилось почти на 30% до 1.8V.

На основе стандарта DDR для видеокарт в 2000 году был разработан новый стандарт памяти GDDR.

Технически GDDR и DDR похожи, только GDDR разработан для видеокарт и предназначен для передачи очень больших объемов данных.

GDDR (Graphics Double Data Rate) расшифровывается как двойная скорость передачи графических данных.

Несмотря на то, что они используются в разных устройствах, принципы работы и технологии для них очень похожи.

Главным отличием GDDR от DDR является более высокая пропускная способность, а также другие требования к рабочему напряжению.

Разработкой стандарта видеопамяти GDDR2 занималась компания NVIDIA. Впервые она была опробована на видеокарте GeForce FX 5800 Ultra.

GDDR2 это что-то среднее между DDR и DDR2. Память GDDR2 работает при напряжении 2.5V, как и DDR, однако обладает более высокими частотами, что вызывает достаточно сильный нагрев. Это и стало настоящей проблемой GDDR2. Долго данный стандарт на рынке не задержался.

Буквально чуть позже компания ATI представила GDDR3, в которой использовались все наработки DDR2. В GDDR3, как и DDR2, реализована технология 4n-Prefetch при операции записи данных. Память работала при напряжении 2V, что позволило решить проблему перегрева, и обладала примерно на 50% большей пропускной способностью, чем GDDR2. Несмотря на то, что разработкой стандарта занималась ATI, впервые его применила NVIDIA на обновленной видеокарте GeForce FX 5700 Ultra. Это дало возможность уменьшить общее энергопотребление видеокарты примерно на 15% по сравнению с GeForce FX 5700 Ultra с использованием памяти GDDR2.

Современные типы видеопамяти

На сегодняшний день наиболее распространенными типами видеопамяти являются GDDR5 и GDDR6, однако до сих пор в бюджетных решениях можно встретить память типа GDDR3-GDDR4 и даже DDR3.

GDDR3

GDDR4

Стандарт GDDR5 появился в 2008 году и пришел на смену стандарту GDDR4, который просуществовал совсем недолго, так и не получив широкое распространение вследствие не лучшего соотношения цена/производительность.

GDDR5 спроектирована с использованием наработок памяти DDR3, в ней используется 8-битовый Prefetch. Учитывая архитектурные особенности (используются две тактовые частоты CK и WCK), эффективная частота теперь в четыре раза выше реальной, а не в два, как было раньше. Таким способом удалось повысить эффективную частоту до 8 ГГц, а вместе с ней и пропускную способность в два раза. Рабочее напряжение составило 1.5V.

GDDR5X — улучшенная версия GDDR5, которая обеспечивает на 50% большую скорость передачи данных. Это было достигнуто за счет использования более высокой предварительной выборки. В отличие от GDDR5, GDDR5X использует архитектуру 16n Prefetch.

GDDR5X способна функционировать на эффективной частоте до 11 ГГц. Данная память использовалась только для топовых решений NVIDIA 10 серии GTX1080 и GTX1080Ti.

Память стандарт GDDR6 появился в 2018 году. GDDR6, как и GDDR5X, имеет архитектуру 16n Prefetch, но она разделена на два канала. Хотя это не улучшает скорость передачи данных по сравнению GDDR5X, оно позволяет обеспечить большую универсальность.

Сейчас данная память активно используется обоими производителями видеокарт в новой линейке NVIDIA серий GeForce 20 и 16 (кроме некоторых решений: GTX 1660 и GTX 1650, так как в них используется память GDDR5). При покупке нужно внимательно изучить характеристики видеокарты, потому как разница в производительности от типа памяти в данном случаи достигает от 5 до 15%. В то время как разница в цене совершенно несущественна.

GDDR5

GDDR6

Также тип памяти GDDR6 активно используется компанией AMD в видеокартах RX 5000 серии.

На начальном этапе GDDR6 способна функционировать с эффективной частотой 14 ГГц. Это позволяет удвоить пропускную способность относительно GDDR5. В дальнейшем эффективная частота будет увеличена, как это происходило с другими типами памяти.

Ищу разницу между GDDR5 и GDDR6 на GTX 1650 и нахожу ее в игровых тестах

реклама

Кто периодически читает мои записи, тот наверняка еще помнит, что не так давно у меня уже был тест видеокарты GTX 1650 с памятью GDDR5 в исполнении Palit StormX и тест видеокарты GTX 1650 Super в исполнении все того же Palit StormX.

В конце прошлой записи из теста видеокарты GTX 1650 GDDR5 я затронул тему о том, что существует вариант GTX 1650 с памятью GDDR6 и предположил, что для видеокарты такого уровня подобная память, скорее всего, будет избыточна. Сегодня я, вооружившись вариантом видеокарты GTX 1650 с памятью GDDR6 проверю это предположение и мы вместе с вами по результатам тестов сделаем выводы, имеет ли смысл оснащать видеокарту такого уровня памятью стандарта GDDR6.

Тестировать я буду видеокарту от ASUS в исполнении PHOENIX (новая версия), которая оснащается одним фирменным вентилятором Axial-tech (таким сейчас оснащаются почти все современные видеокарты от ASUS) и позиционируется производителем как компактная видеокарта. По правде говоря, ее компактность заключается лишь в ее длине 178 мм. В высоту и глубину видеокарта вполне себе взрослых размеров. Да и в длину, если сравнить ее с той же GTX 1650 Palit StormX видеокарта от ASUS заметно так крупнее.

реклама

Система охлаждения видеокарты представляет из себя крупный алюминиевый цельный радиатор с большим количеством толстых ребер, занимающий всю площадь видеокарты. В отличие от варианта от Palit, где радиатор контактирует только с чипом GPU, радиатор на видеокарте от ASUS контактирует (через термопрокладки) и с микросхемами памяти, и с подсистемой питания. Видеокарта также оснащена разъемом дополнительного питания на 6-pin.

реклама

Что касается технических характеристик, то по части GPU это все та же GTX 1650, по части же видеопамяти она повторяет старшую GTX 1650 Super. Оснащение видеокарты памятью стандарта GDDR6 позволило ей поднять пропускную способность со стандартных 128 ГБ/с до уровня 192 ГБ/с, как у старшей GTX 1650 Super. Обращаю ваше внимание, что значения энергопотребление бралось из общих для видеокарт паспортных данных. Фактически же ASUS GTX 1650 GDDR6 PHOENIX потребляет примерно на 20-30 ватт больше, чем стандартная GTX 1650 и приближается к значениям в 100 ватт.

реклама

И прежде, чем перейти непосредственно к самим тестам, хотелось бы отметить один интересный факт, всплывший во время эксплуатации данной видеокарты. Запустив утилиту GPU-Z я обнаружил, что видеокарта построена на базе старшего чипа TU106, ровно того самого, который лег в основу RTX 2060. Для сравнения, GTX 1650 Super от Palit StormX основан на чипе TU116. А вариант GTX 1650 с памятью GDDR5 от того же Palit StormX базируется на TU117. Для сравнения привожу вам два снимка из программы для ASUS GTX 1650 GDDR6 и Palit GTX 1650 Super. Обратите внимание, интересным отличием является не только более старший вариант чипа у младшей видеокарты, но и его физический размер и количество транзисторов.

Имеет ли это какое-то практическое значения, честно говоря, не знаю. Поэтому просто принимаем данную информацию как интересный факт.

Тесты видеокарты я буду проводить в тех же самых играх, на тех же самых настройках и в тех же самых условиях, что и в прошлый раз. Это даст нам возможность сравнивать полученные результаты с уже имеющимися результатами и понять, какое место данная видеокарта займет в сравнении с GTX 1650 GDDR5 и GTX 1650 Super. Все видеокарты во время теста эксплуатировались в штатном режиме. Частота графического процессора для всех карт во время тестов составляет в среднем около 1900 МГц.

Все тестовые отрезки были взято из этой записи. С настройками можно ознакомиться здесь. Все замеры производились программой FRAPS.

Тестовая конфигурация выглядит следующим образом:

Ультра пресет настроек, разрешение 1920×1080. Вариант GTX 1650 с памятью GDDR6 расположилась «почти» посередине между GTX 1650 с памятью GDDR5 и старшей GTX 1650 Super. Хотя, конечно, к своему прямому конкуренту видеокарта все же заметно ближе. GTX 1650 Super обходит GTX 1650 GDDR6 на 25%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 11%. Все три видеокарты обеспечивают достаточный для игры комфортный уровень показателя фреймрейта.

Ручные настройки графики, двукратный мультисемплинг, разрешение 1920×1080. Ситуация в целом повторяет предыдущую. GTX 1650 GDDR6 расположилась посередине, но ближе к своему прямому конкуренту в лице GTX 1650 GDDR5. GTX 1650 Super обходит GTX 1650 GDDR6 на 22%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 8%. Все три видеокарты обеспечивают комфортный показатель фреймрейта.

Максимальный пресет графики, четырехкратный мультисемплинг, разрешение 1920×1080. А вот здесь уже ситуация заметно поменялась и GTX 1650 GDDR6 умудряется оказаться ближе к старшей GTX 1650 Super, нежели к своему младшему брату-близнецу. Это в особенности бросается в глаза по показателю максимального показателя фреймрейта. По среднему фреймрейту GTX 1650 Super обходит GTX 1650 GDDR6 на 4%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 14%. Все три видеокарты обеспечивают комфортный показатель фреймрейта в данной игре.

Максимальный пресет настроек графики, разрешение 1920×1080. В Far Cry 5 GTX 1650 GDDR6 вновь оказалась ближе к своему прямому конкуренту с памятью GDDR5. GTX 1650 Super обходит GTX 1650 GDDR6 на 20%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 8%. При этом младший вариант с памятью GDDR5 опускается чуть ниже 60 кадров по среднему значению фреймрейта, вариант с памятью GDDR6 оказывается чуть выше этого значения.

Средний пресет графики, тесселяция отключена, HairWorks отключен, разрешение 1920×1080. В Metro Exodus ситуация напоминает DiRT Rally, в которой видеокарта GTX 1650 с памятью GDDR6 практически сравнялась со старшей GTX 1650 Super по показателю максимального фреймрейта. Однако по среднему показателю все не так радужно, видеокарта находится примерно посерединке между двумя другими видеокартами. GTX 1650 Super обходит GTX 1650 GDDR6 на 18%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 16%. Комфортно поиграть удастся на всех трех видеокартах.

Ручные настройки из прошлой записи, разрешение 1920×1080. В Resident Evil 2 Remake GTX 1650 с памятью GDDR6 оказывается посередине между остальными участниками, ближе к своему младшему конкуренту. GTX 1650 Super обходит GTX 1650 GDDR6 на 16%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 8%.

Максимальные настройки графики, сглаживание FXAA, разрешение 1920×1080. В Rise of The Tomb Raider GTX 1650 GDDR6 вновь оказывается где-то посерединке, чуточку ближе к младше видеокарте. GTX 1650 Super обходит GTX 1650 GDDR6 на 18%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 15%. При этом значение среднего фреймрейта выше 60 кадров показывают только GTX 1650 Super и GTX 1650 GDDR6.

Максимальные настройки графики, сглаживание TAA, разрешение 1920×1080. И вновь мы наблюдаем, как видеокарта GTX 1650 с GDDR6 памятью оказывается между GTX 1650 Super и GTX 1650 с памятью GDDR5, располагаясь несколько ближе именно к младшему варианту. GTX 1650 Super обходит GTX 1650 GDDR6 на 21%. GTX 1650 GDDR6 обходит GTX 1650 GDDR5 на 15%. Комфортно поиграть получится на всех трех видеокартах.

Сводный график всех результатов с учетом предыдущих тестов, включающий также видеокарту RX 560 2GB:

RX 560 2GB ожидаемо располагается далеко позади всех остальных видеокарт, все же это видеокарта другого уровня. Остальные же участники располагаются в ровную линеечку недалеко друг от друга. GTX 1650 Super на первом месте, GTX 1650 GDDR5 на последнем месте. Но комфортный уровень средней частоты кадров показывают обе видеокарты. GTX 1060 3GB за счет разгона смогла пробиться на второе место, сумев обойти GTX 1650 GDDR6, но без разгона, скорее всего, она оказалась бы между GTX 1650 GDDR5 и GTX 1650 GDDR6. В среднем разница между соседними видеокартами составляет порядка 10%.

Выводы

Глядя на некоторые результаты немножко даже не верится, что такое может быть. Только благодаря более скоростной видеопамяти GTX 1650 GDDR6 местами умудряется не просто отрываться от GTX 1650 GDDR5, но и даже оказываться ближе к старшей GTX 1650 Super. Держим в голове тот факт, что GTX 1650 GDDR6 и GTX 1650 GDDR5 отличаются только видеопамятью, тогда как GTX 1650 Super отличается от них более мощным GPU, обходя оба младших решения на 43% по количеству вычислительных ядер CUDA. Оттого результаты выглядят еще более удивительными и впечатляющими. Пожалуй, стоит признать, что я сильно ошибался в своем предположении о том, что для видеокарты такого уровня более скоростная видеопамять может быть избыточна. Кроме того, исходя из результатов и различиях в GPU, смею предположить, что старшую GTX 1650 Super на самом деле тоже сдерживает видеопамять, и с более скоростной (более широкой шиной) она показывала бы более высокие и логичные результаты.

И, конечно же, я не забыл про бенчмарк Neon Noir Ray Tracing, оставив его напоследок.

Результаты здесь уже не вызывают никаких удивлений, скорее закономерность. GTX 1650 с памятью GDDR6 в штатном режиме показывает тот же результат, что GTX 1650 с памятью GDDR5 в разгоне. Разгон же GTX 1650 с памятью GDDR6 ставит ее, очевидно, еще выше, но до старшей GTX 1650 Super все еще далековато. GTX 1650 Super даже в штатном режиме обходит GTX 1650 GDDR6 с разгоном на 20%. К слову о разгоне. Искать предельные значения по GPU я не стал, установил стандартные 2000 МГц, чтобы все три видеокарты были в равных условиях. По памяти же сходу удалось получить рабочие 14000 МГц. Пробовать выше не стал, т.к. думаю, что и этот результат вполне достойный для данной видеокарты.

Напоследок затрону температурный режим видеокарты и вот здесь все оказалось не так просто и очевидно. Несмотря на более крупную и серьезную систему охлаждения, видеокарта греется даже сильнее, чем оба других варианта от Palit StormX, в среднем мы имеем температуру порядка 65-67 градусов. Причем как ни странно, самой холодной оказалась самая компактная GTX 1650 с памятью GDDR5 от Palit StormX, ее температуры едва ли переваливают за показатель в 60 градусов. GTX 1650 Super от Palit StormX по температурам близка к варианту GTX 1650 от ASUS и прогревается примерно до 63-65 градусов. И тут мне в голову приходит несколько теорий по этому поводу. Во-первых, радиатор на обеих видеокартах от Palit StormX не имеют контакта с памятью и подсистемой питания, там весь радиатор целиком охлаждает только GPU, тогда как в варианте от ASUS радиатору приходится охлаждать и GPU, и GDDR6 память и зону VRM. Во-вторых, это уже больше из области теории заговора, но допускаю, что TU106 сам по себе может быть более прожорливым несмотря на равное количество вычислительных процессоров. Что касается оборотов вентилятора, то здесь такая же странная ситуация. Напомню, что мониторинг показателя количества оборотов в минуту на видеокартах от Palit StormX нет, только процентное значение. И там значения оборотов в среднем достигали 40-45%. На ASUS это значение под нагрузкой может достигать 65-70%, что соответствует 1800-2200 оборотам в минуту, благо на видеокарте от ASUS мониторинг количества оборотов присутствует. При этом шум становится заметным в основном именно с этих значений. До 60-65% он остается скорее фоновым. Если же говорить о шуме в целом, то именно по уровню, опять же, как ни странно, самой тихой оказалась самая маленькая GTX 1650 с памятью GDDR5 от Palit StormX. Маленький вентилятор на ней не создает именно высокого уровня шума, но создает характерное для небольших вентиляторов «звучание» в работе. Вентилятор на ASUS создает привычный звук «потока воздуха», но делает это громче. GTX 1650 Super от Palit StormX оказывается где-то посередине между ними и по уровню, и по характеру.

GDDR6X против GDDR6: сравнение графической памяти, стоит ли оно того?

NVIDIA Ампер графика карты были первыми, кто включил GDDR6X графическая память, следующий шаг к GDDR6 с точки зрения производительности. Благодаря этой памяти им удалось сравняться с 21 Гбит / с полосы пропускания которые у нас были в то время, но они достигли этого новаторским способом, который дает множество преимуществ… и некоторые недостатки. Стоило ли изменение того? Давай увидим это.

GDDR6X против GDDR6, чем они отличаются?

На данный момент ни у кого не будет сомнений в том, что GDDR6X представляет собой скачок во многих отношениях по сравнению с графической памятью GDDR6, поэтому, если у кого-то были какие-либо сомнения, они уже могли их развеять: с точки зрения производительности GDDR6X превосходит, и это причина почему NVIDIA рискнула внедрить в свою архитектуру Ampere видеокарты, ни больше, ни меньше.

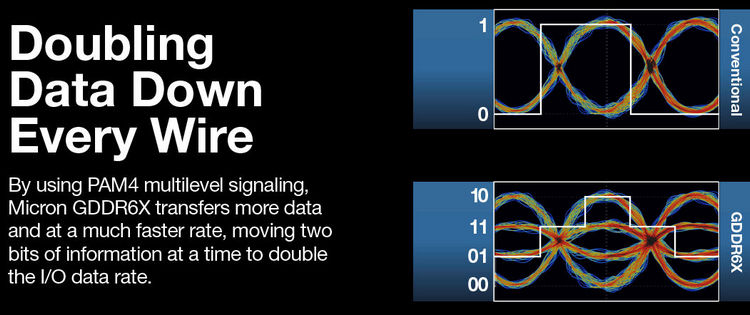

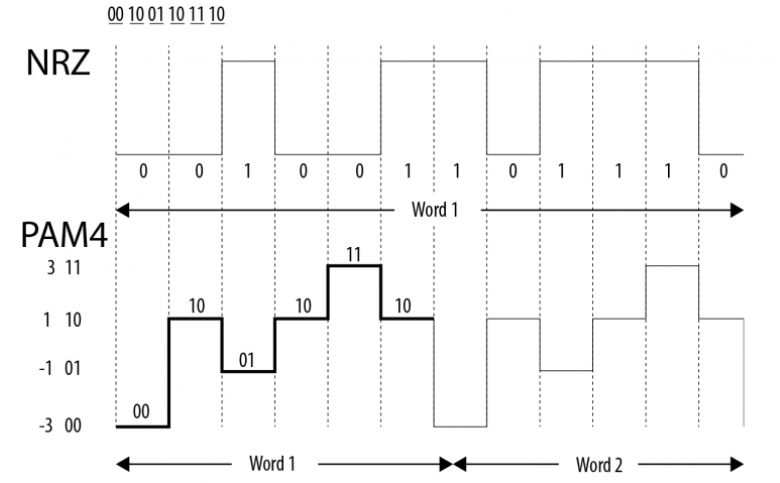

Чтобы добиться такого повышения производительности, Micron использовал технологию, которая уже использовалась в сетевой электронике, не продвигаясь дальше, а именно использование кодирования PAM4, а не кодирования. Кодировка NRZ GDDR6 . PAM расшифровывается как Pulse Amplitude Modulation, и что он делает, так это то, что он способен генерировать различные двоичные значения, используя амплитуду электрического сигнала.

Таким образом, хотя кодирование NRZ способно генерировать только единицы и нули, PAM4 способен генерировать четыре двоичных значения за такт, поэтому он способен кодировать 2 бита за цикл по сравнению только с 1 из NRZ, таким образом удваивая полосу пропускания.

Micron может похвастаться тем, что переосмыслил память с помощью этой новой технологии, и NVIDIA очень сильно на нее сделала. Конечно, потенциал, который он предоставляет, огромен, и вы можете достичь невиданного ранее уровня производительности памяти.

Стоит ли менять?

Теперь использование этого типа графической памяти также имеет ряд технических недостатков в дополнение к уже упомянутому, который заключается не более чем в том факте, что Micron производит его исключительно, регулируя его цену и производство (это делает GDDR6X более дорогим и меньше, чем GDDR6).

Используя кодирование PAM4, мы уже объясняли, что за такт генерируется 4 двоичных значения, что позволяет кодировать 2 бита за такт по сравнению с 1 при кодировании NZR. Это делает контроллер напряжения намного более важным, а неисправность его чувствительности может вызвать ошибки памяти, вызывающие наименьшее количество ошибок чтения / записи во VRAM и приводит к проблемам с артефактами, зависаниям, синим экранам и т. д.

Это не означает, что GDDR6X будет иметь ошибки памяти далеко не так, но он просто будет намного более чувствительным и подверженным им и будет намного больше зависеть от контроллера. Положительным моментом является то, что, поскольку он работает при более низком напряжении и выделяет меньше тепла, этот недостаток частично компенсируется.

Отвечая на вопрос о том, стоил ли переход на эту новую технологию памяти, конечно же, да. Хотя в настоящее время он не использует весь свой потенциал с точки зрения производительности, есть возможность удвоить пропускную способность памяти, и на данный момент они уже справились. значительно снизить потребление и выделяемое тепло, что уже является преимуществом, которое того стоит.

Теперь еще предстоит увидеть, что ждет арену VRAM в будущем. У NVIDIA есть большой потенциал для использования с этим типом памяти, но мы по-прежнему находимся за счет «ответа» со стороны AMD в этом отношении, поскольку они также дали свои обещания. С другой стороны, NVIDIA была пионером в использовании GDDR6X, но мы не можем забыть, что AMD была предшественницей памяти HBM, которая позже обернулась фиаско.